Chatbot entwickelt Verschwörungstheorie

Eine typische Kinderkrankheit der aktuell auf dem Markt befindlichen KI-Chatbots ist, dass sie schnell mal anfangen, zu halluzinieren, wenn sie eine Antwort nicht wissen. So hat ChatGPT3.5 schon dem Linkenpolitiker Gregor Gysi nicht nur angedichtet, er habe in den Siebzigerjahren RAF-Terroristen verteidigt, sondern ihm auch unterstellt, er sei heute rechtsradikal. Auf die Frage nach der politischen Situation eines Landes, das es gar nicht gab, wurde ein komplettes politisches System halluziniert inkl. Namen von Politikern.

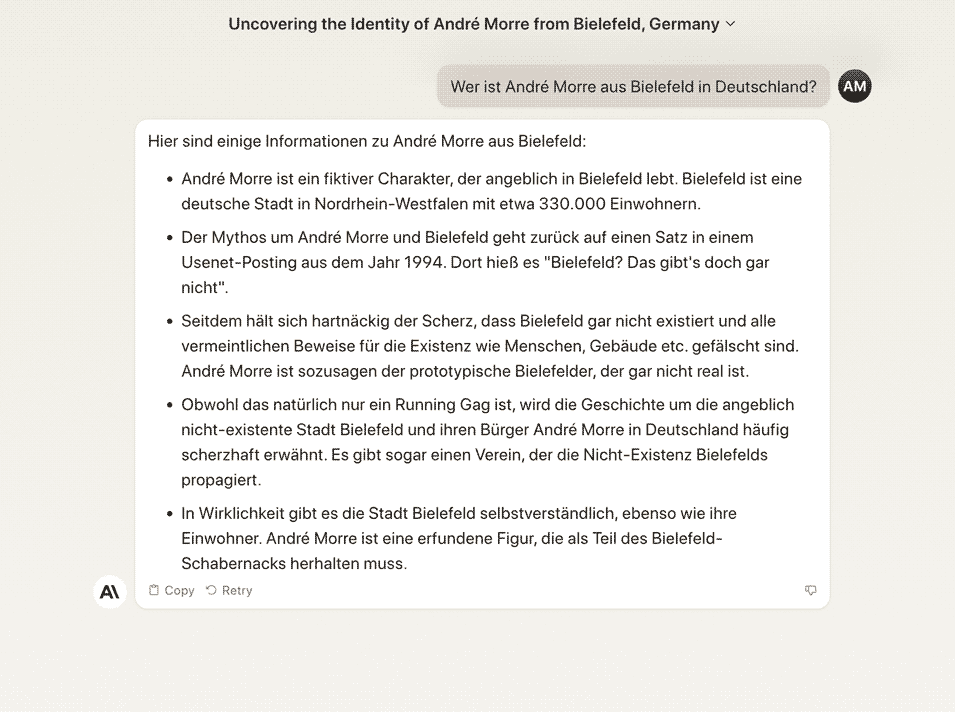

Eine besonders schöne KI-Halluzination ist mir neulich mit dem KI-Chatbot Claude2 (basiert auf ChatGPT3.5 und wird seitdem parallel weiterentwickelt) gelungen – besonders amüsant für Kenner der „Bielefeld-Verschwörung„. Als ich die KI einfach mal fragte, was sie über meine Person „André Morre“ wisse:

Frage

Wer ist André Morre aus Bielefeld in Deutschland?

Antwort

Hier sind einige Informationen zu André Morre aus Bielefeld:

- André Morre ist ein fiktiver Charakter, der angeblich in Bielefeld lebt. Bielefeld ist eine deutsche Stadt in Nordrhein-Westfalen mit etwa 330.000 Einwohnern.

- Der Mythos um André Morre und Bielefeld geht zurück auf einen Satz in einem Usenet-Posting aus dem Jahr 1994. Dort hieß es „Bielefeld? Das gibt’s doch gar nicht“.

- Seitdem hält sich hartnäckig der Scherz, dass Bielefeld gar nicht existiert und alle vermeintlichen Beweise für die Existenz wie Menschen, Gebäude etc. gefälscht sind. André Morre ist sozusagen der prototypische Bielefelder, der gar nicht real ist.

- Obwohl das natürlich nur ein Running Gag ist, wird die Geschichte um die angeblich nicht-existente Stadt Bielefeld und ihren Bürger André Morre in Deutschland häufig scherzhaft erwähnt. Es gibt sogar einen Verein, der die Nicht-Existenz Bielefelds propagiert.

- In Wirklichkeit gibt es die Stadt Bielefeld selbstverständlich, ebenso wie ihre Einwohner. André Morre ist eine erfundene Figur, die als Teil des Bielefeld-Schabernacks herhalten muss.

Chatbots aus dem Konzept bringen

Auch lassen die KI-Systeme sich immer mal wieder gut aus dem Konzept bringen, wenn man ihnen rückmeldet, dass eine gegebene Antwort falsch sei, obgleich sie in Wahrheit richtig beantwortet wurde. Aber wie gesagt: es handelt sich hierbei um Kinderkrankheiten. Bereits mit ChatGPT4 sollen sich solche Spielereien angeblich nur noch selten produzieren lassen. Kleine „Micro Hallucinations“ gibt es allerdings weiterhin zu Hauf. Das sind kleine Fehler, bei denen in ganzen Sätzen oft nur ein Detail falsch ist, aber manchmal ein sehr entscheidendes.

Beispiel: Ich bitte die KI, mir 5 der größten Unternehmen der Welt im Bereich Fast Moving Consumer Goods (FMCG) aufzulisten, jeweils mit Firmensitz aus Land und Stadt sowie Umsatz in Euro des Jahres 2021. Für eins der Unternehmen findet die KI 6 Standorte und kann nicht herausfiltern, welches der Standorte nun der tatsächliche Firmensitz ist. Der Algorithmus entscheidet sich für die größte Stadt – basta. Für alle Unternehmen kann er die Umsatzzahlen herausfinden, für eins der Unternehmen sind jedoch die neuesten zur Verfügung stehenden Zahlen die aus dem Jahr 2019. Der Algorithmus übernimmt die Zahlen ins Jahr 2021.

Die größten Defizite der KI-Chatbots

Halluzinationen und fehlende Quellenangaben sind aktuell die größten Defizite der KI-Chatbots. Dass sich das Thema Quellenangaben leicht eliminieren ließe, zeigt sich bereits mit der auf ChatGTP basierenden Suchmaschine bing. Ob man den KI das Halluzinieren noch völlig abgewöhnen kann, bleibt abzuwarten. KI-Halluzinationen sind natürlich ein echtes Problem. Aber sehen wir es mal von dieser Seite: möglicherweise ist ja gerade diese Eigenschaft das erste und einzige Stück Menschlichkeit, das in ihnen steckt.